GPU服务器和通用服务器是目前服务器市场根据业务场景进行的细分,并没有严格意义上的定位,你可以理解为GPU服务器是通用服务器为了更好支持GPU进行的优化设计。

一、GPU卡支持的数量不同

1、GPU服务器通常在GPU卡的支持上至少4张起,市场主流的有4卡、8卡、10卡、20卡等,这里的卡指的是标准双宽卡,以下是国内某大厂GPU服务器的后视图,供参考。

2、通用服务器:一般2U的不超过4卡,4U的不超过6卡,也是指的标准双宽卡。

二、GPU卡支持类型不同

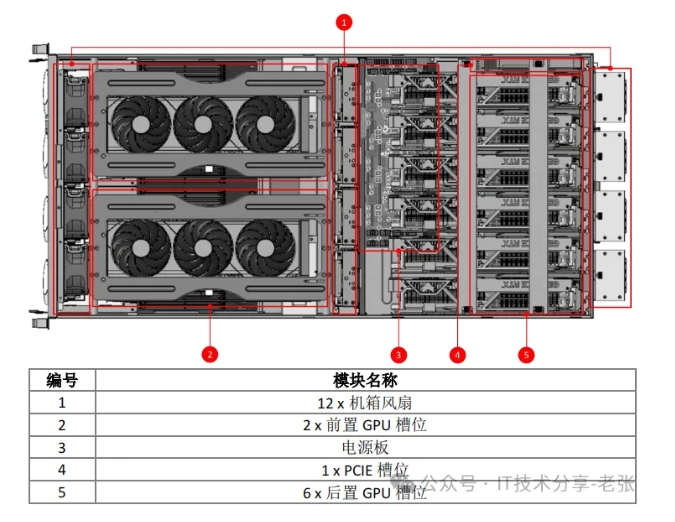

1、GPU服务器:对卡的兼容性很好,除了单宽、双宽,部分厂商的机型还能支持消费类的2.5或3宽游戏卡,比如四通推出的G5208支持8卡的风扇版4090,就是比较创新的一款机器,其GPU支持参数和结构图如下。

三、机器形态不同:

1、GPU服务器:通常都是单节点形态,市场上以4U为主,还有机塔互转形态,也有高 端的NVlink机型是5U、6U或8U;

2、通用服务器:通常是2U的形态,也有1U高度,高密的2U2、2U4、4U8、刀片或者整机柜,产品形态更丰富;

四、GPU与CPU拓扑不同:

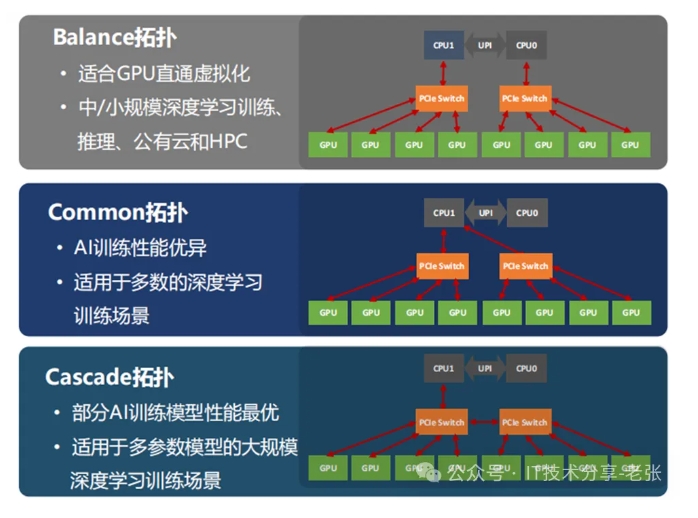

1、GPU服务器:除了PCIE直通还可以通通过PCIE sw进行扩展,拓扑类型多样,有balance、common和cascade,针对不同的客户业务场景(训练、推理、视频渲染等)可以更加灵活的选择,具体如下图。

2、通用服务器:通常是PCIE直通(通过PCIe sw的很少见),而且支持的GPU数量有限;

五、服务器的品牌不同:

1、GPU服务器:除了头部大厂是自己研发的平台(LC、H3C、C J B、LX等等),其他大多数用的超微的平台(当然不排除其他的ODM厂家,比如HQ、HS等)。

2、通用服务器:叫上名字的有大几十家,除了头部几家自研程度高以外,一般都是以攒机为主(实事求是讲,不接受反驳),主打性价比;

六、整机功耗差距很大:

1、GPU服务器:功耗偏高,以4090八卡机为例,一台服务器要4KW以上,比如市场主流的超微8卡平台,通常就是2+2的2KW电源(当然也可以设置为3+1的工作模式);

2、通用服务器:低配的一般为500-550w,还有800W、100W、1200W和1600W,通常超过2KW的不多;

七、单台服务器价格不同:

1、GPU服务器:平台就是通用服务器的2-3倍,实际出货一台轻松过十万,大几十万到上百万也是正常,这个主要是取决于GPU卡的价格,比如8卡A100,平台的成本占比就很小了。

2、通用服务器:价格范围就很大,1-2w到几十万不等,但是以10W以下需求居多,均价大概3-5w一台,这也是为什么现在大家都喜欢卖GPU服务器的原因,一台顶十台,出几十台台4090八卡机,销售的业绩任务基本上就达成了。

八、整体的市场份额不同:

时间往前倒退2年,整个服务器市场规模,GPU服务器占比约为20-25%,而标准的服务器占比高达70%以上,现在GPU市场火爆,尤其是AIDC的建设,粗略估算GPU类的机型出货已经超过3或4成(如下图,是IDC统计的23年国内加速服务器市场的市占比超过了30%)。

九、服务器的业务场景定位不同:

GPU服务器一般是视频渲染图形处理、做AI训练、AI推理或者HPC计算为主,而标准服务器哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。

十、液冷技术需求的迫切性不同:

GPU服务器都是“电老虎”,也是智算中心降低PUE指标的关键,因此目前很多在建或者准备建设的智算中心都规划了GPU服务器的液冷(冷板和浸没式的都有),但是风险点是GPU卡的保修,一旦对GPU卡进行液冷改造的手术,一般会影响原厂的质保(当然这个问题是暂时的,不排除后面GPU厂商推出专门的液冷型号,其实2年前英伟达就推出过一款A100单宽的液冷GPU,见下图),通用服务器在液冷维度迫切性不如GPU服务器(但是通用服务器结构相对简单在液冷冷板改造还是浸没式适配方面要比GPU服务器更加成熟);

来源: IT技术分享-老张 公众号